当外界信息通过感官系统,传到大脑时,大脑对其做一个简单的模式分析和识别,再将其交给对应的处理区域。

在学习过程中,大脑接收的信息越多,各个区域存储的模式以及模式之间的联系也就越多。如此积累下去,大脑逐渐理解模式分类的规则以及模式之间的联系,最终形成我们对世界各种事物的认知。

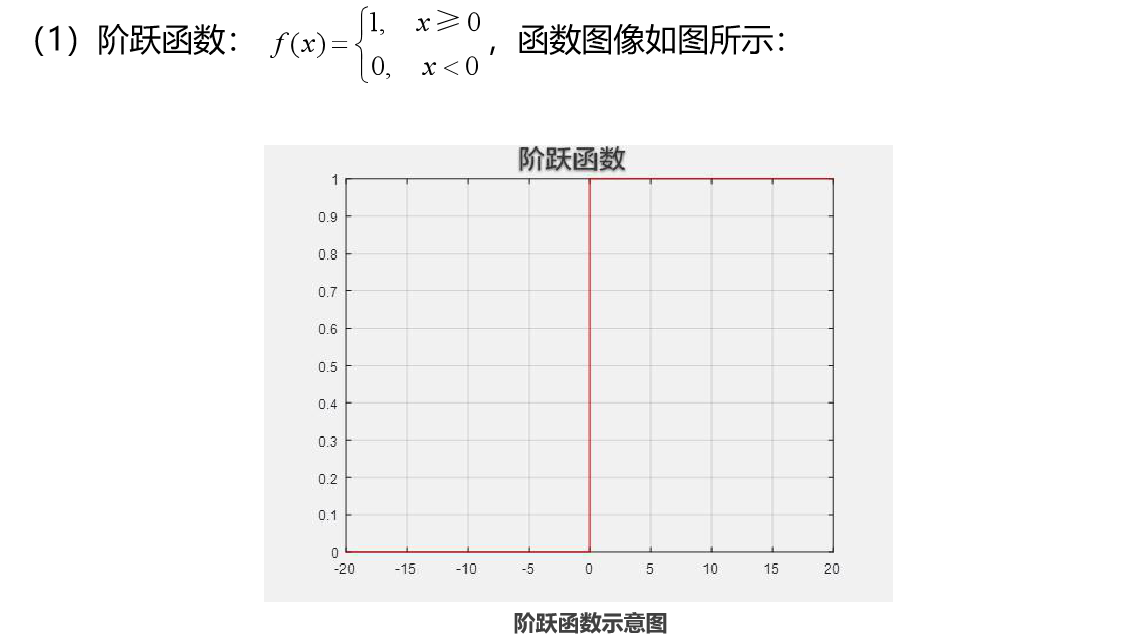

激活函数:

阶跃函数

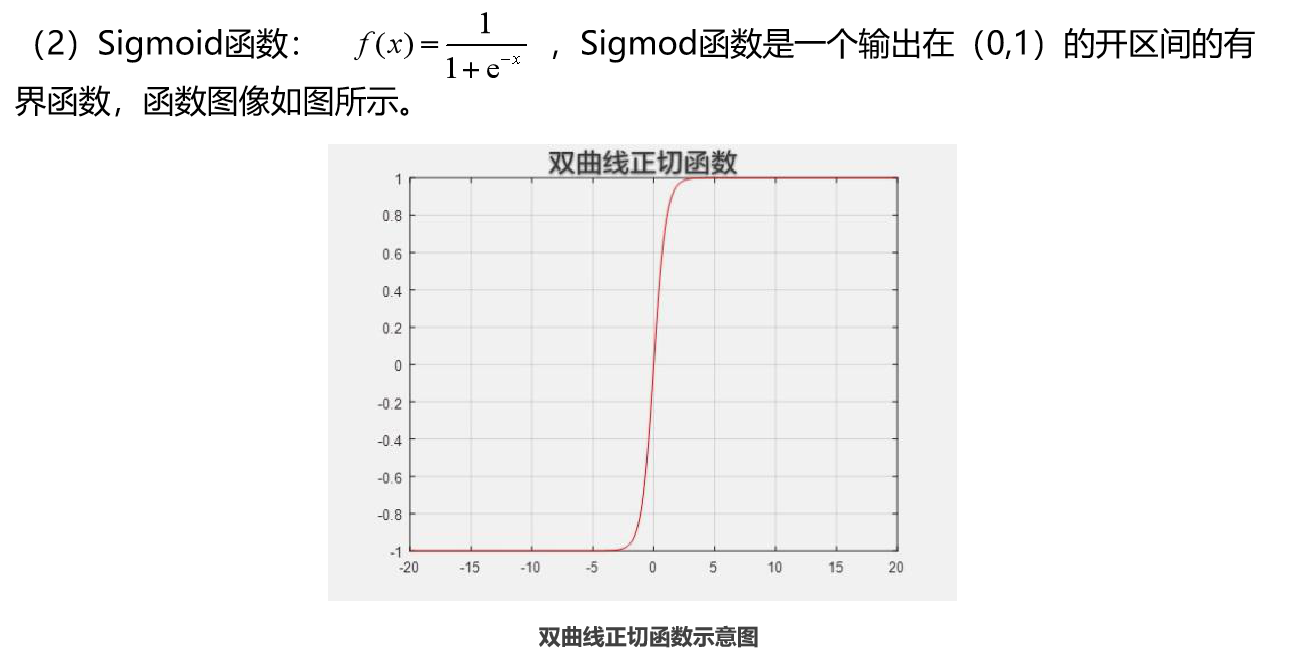

Sigmoid函数

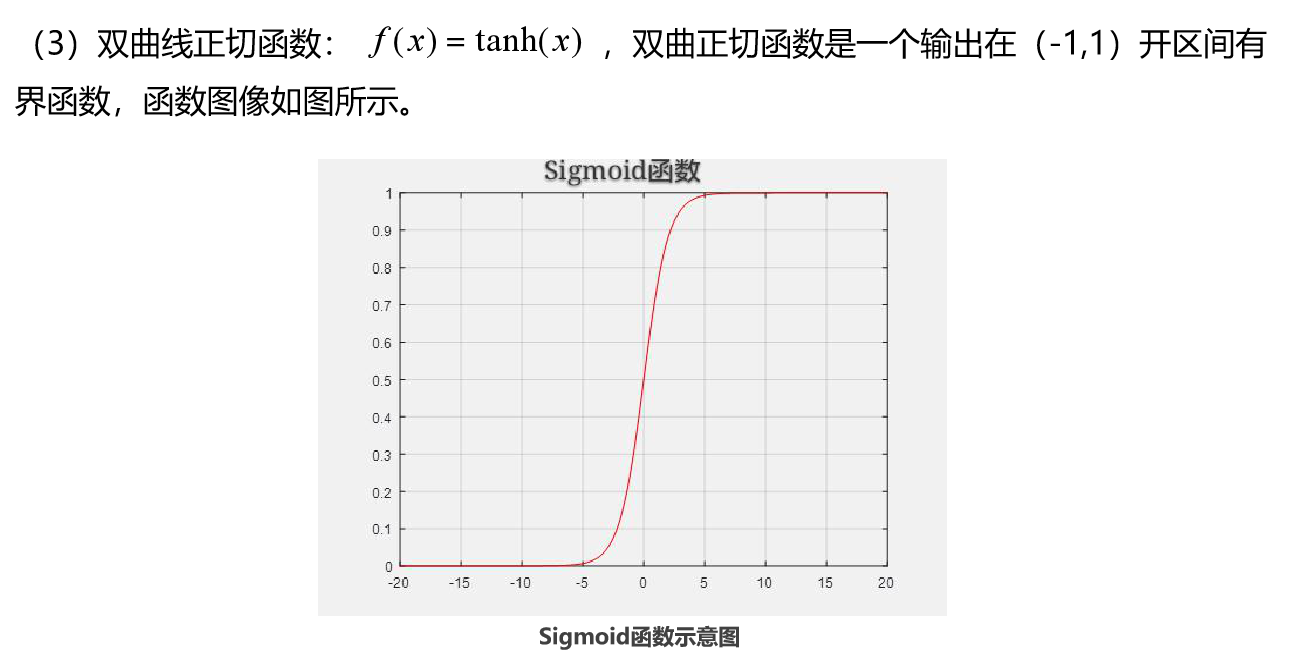

双曲线正切函数

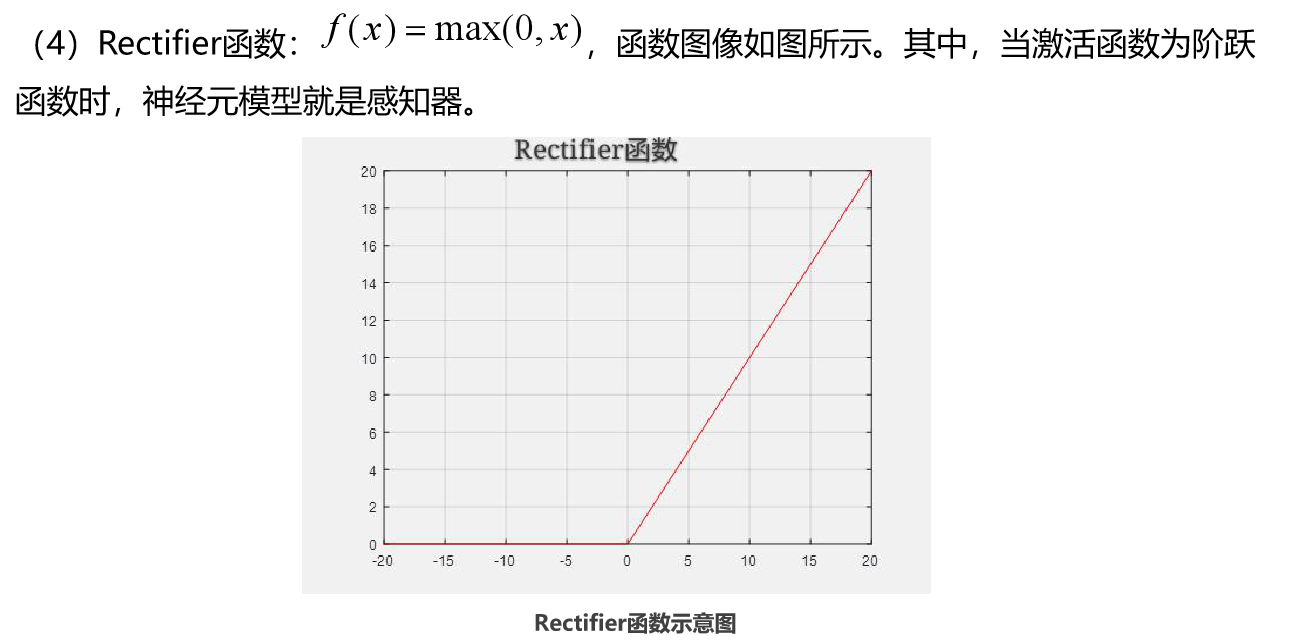

Rectifier函数

多层网络的学习能力比单层感知机强得多,如果想要训练多层网络,误差逆传播(简称BP)是迄今为止最杰出的神经网络学习算法。BP是一种按误差逆传播算法训练的多层前馈网络,是目前应用最广泛的神经网络模型之一。

卷积神经网络

包含三种类型的层,分别是卷积层、下采样层及全连接层。通过卷积核与上一层输出进行卷积作为卷积层的输出,这样可以达到权值共享的目的;下采样是在卷积层的基础上,在一个固定区域中采样一个点,使得整个网络具有一定的缩放、平移及形变不变性。

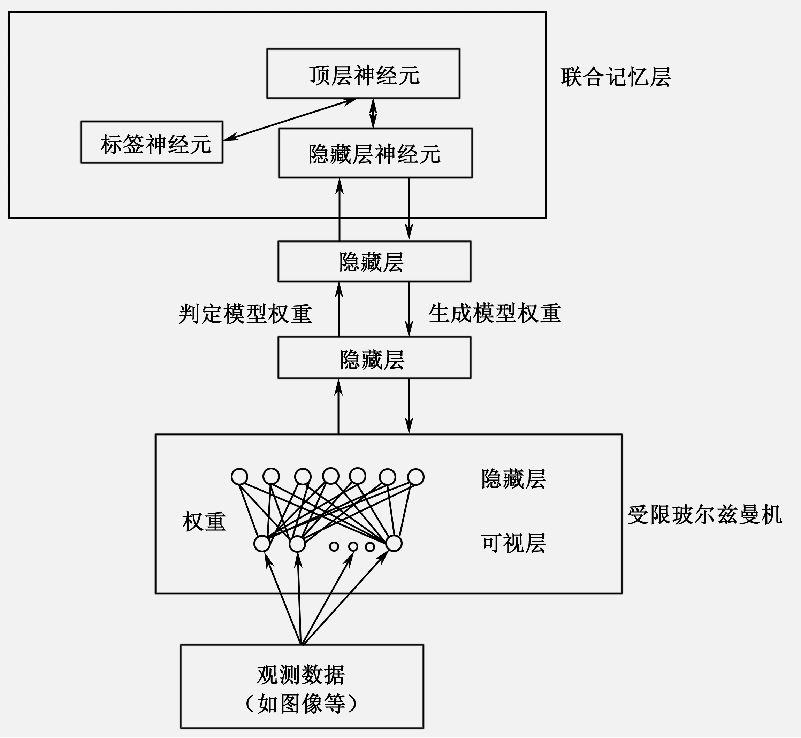

深度置信网络

由若干层受限玻尔兹曼机及一个反向传播网络组成。深度置信网络的训练过程分为两步,首先利用贪婪算法无监督地训练每一层受限玻尔兹曼机,然后将上一步训练得到的数据作为网络初始值,利用BP算法有监督地训练整个网络。

循环神经网络

该网络与传统前馈网络的区别在于,隐层的输入不仅包括输入层的数据,还包括前一时刻的隐层数据。这种结构的网络能有效处理序列数据,如自然语言处理。

局部感受区域

在卷积神经网络中,神经元只对视野中的某一区域产生响应,被称为局部感受区域。

最底层是摄入的原始信息像素,往上逐渐组织形成一些边缘特征,再向上,边缘特征组合形成更有表现力的物体局部特征,到了最顶层,不同的高级特征组合起来,形成最终完整的人脸图像。

权值共享

一个卷积层中的所有神经元均由同一个卷积核对不同区域数据响应而得到的,即共享同一个卷积核。

局部连接的卷积核会对全部图像数据进行滑动扫描,使得卷积层训练参数的数量急剧减少,提高了网络的泛化能力。此外,权值共享意味着一个卷积层中的神经元均在检测同一种特征,与所处位置无关,所以,具有平移不变性。

降采样

一般在卷积层后面会进行降采样操作,对卷积层提取的特征进行聚合统计。

一般的做法是将前一层的局部区域值映射为单个数值,与卷积层不同的是,降采样区域一般不存在重叠现象。降采样简化了卷积层的输出信息,进一步减少了训练参数的数量,增强了网络的泛化能力。